在當今的數字化時代,大型網站已成為連接用戶、服務和數據的超級樞紐。其背后支撐的海量數據處理能力,是保障網站高可用、高性能和高擴展性的基石。大型網站的架構設計,在很大程度上是圍繞數據的高效處理、安全存儲與智能應用展開的一場系統工程。

一、大型網站數據處理的核心挑戰

大型網站的數據處理面臨著前所未有的挑戰:

- 數據規模巨大:每日產生PB級甚至EB級的用戶行為、交易、日志等數據,傳統的單機存儲與計算模型完全失效。

- 高并發訪問:數以億計的用戶同時在線,對數據庫的讀寫請求呈爆發式增長,要求極低的響應延遲。

- 數據多樣性:包括結構化數據(如用戶信息)、半結構化數據(如JSON日志)和非結構化數據(如圖片、視頻),需要不同的處理技術。

- 高可用性與一致性要求:系統必須保證7x24小時不間斷服務,同時在分布式環境下平衡數據的一致性、可用性和分區容錯性(CAP定理)。

- 實時性需求:從用戶點擊到推薦反饋,從風險交易識別到監控告警,對實時數據處理(流處理)的能力要求越來越高。

二、核心架構技術與分層處理

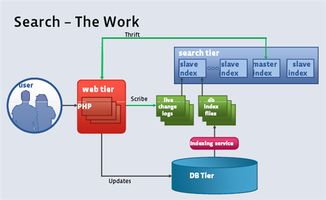

為應對上述挑戰,現代大型網站通常采用分層的、分布式的數據處理架構:

1. 數據存儲層:分而治之

- 讀寫分離與分庫分表:將數據庫拆分為主庫(寫)和多個從庫(讀),并進一步將大表按業務維度(如用戶ID、時間)水平拆分,以分散壓力。

- 多類型數據庫并存(Polyglot Persistence):根據數據特性選用最佳存儲。例如,關系型數據庫(如MySQL、PostgreSQL)處理核心交易;NoSQL數據庫(如Redis用于緩存、MongoDB用于文檔存儲、HBase用于海量明細);以及對象存儲(如Amazon S3)存放靜態文件。

2. 數據緩存層:加速訪問

- 緩存無處不在:在應用層(本地緩存)、數據庫前(分布式緩存如Redis、Memcached)、甚至CDN層面建立多級緩存,將熱點數據的訪問路徑縮短,極大減輕后端存儲壓力。

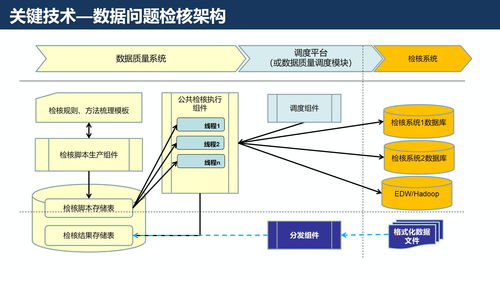

3. 數據處理與計算層:批量與流式并舉

- 離線批量處理:針對海量歷史數據的深度分析,采用以Hadoop HDFS、Spark為核心的大數據平臺,進行ETL、數據挖掘和報表生成。

- 實時流處理:針對即時性要求高的場景,使用Flink、Storm、Spark Streaming等流計算框架,對數據流進行實時過濾、聚合與計算,支撐實時大屏、個性化推薦和風控。

4. 數據同步與集成層:連接孤島

- 通過消息隊列(如Kafka、RocketMQ)實現應用解耦和異步處理,同時它也是流處理的數據源。

- 使用數據同步工具(如Canal、Debezium)進行數據庫的增量日志捕獲與復制,實現異構數據源之間的實時同步。

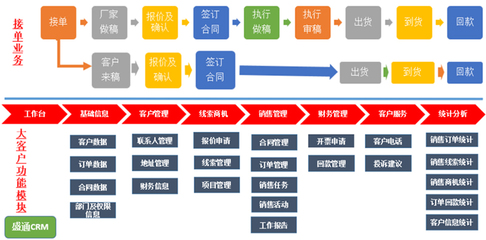

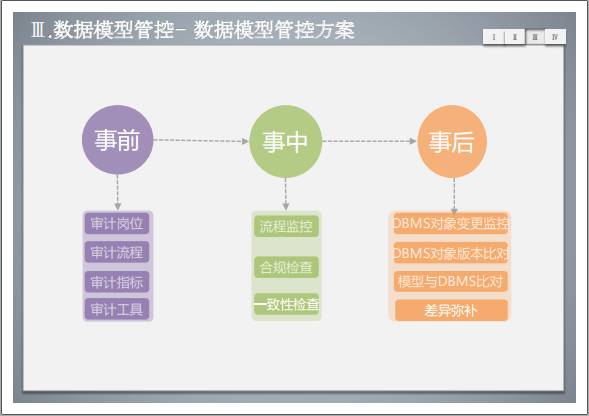

5. 數據服務與治理層:賦能業務

- 通過統一的數據API、數據中臺或數據湖,將處理好的數據以服務形式提供給前端業務應用。

- 建立元數據管理、數據質量監控和數據血緣追蹤體系,確保數據的可信、可靠與安全合規。

三、技術演進與未來趨勢

大型網站的數據處理架構始終在快速演進:

- 從On-Premise到Cloud-Native:云原生技術(Kubernetes、Serverless)使得數據基礎設施可以按需彈性伸縮,運維自動化程度更高。

- 從Lambda到Kappa架構:流處理能力的強化,使得更多場景可以用一套流處理系統同時處理實時和歷史數據,架構更簡潔。

- 從數據處理到數據智能:隨著機器學習平臺的集成,數據處理管道不僅用于存儲和分析,更直接用于訓練和部署AI模型,實現智能搜索、推薦和自動化決策。

- 實時數倉與數據湖倉一體化:打破離線與實時的壁壘,構建能同時支持實時查詢與分析的統一數據平臺(如Delta Lake、Apache Iceberg)。

###

大型網站的數據處理架構是一個復雜而精密的生態系統,其核心目標是在數據爆炸的時代,確保數據能夠被高效、穩定、安全地轉化為業務價值。它沒有一成不變的銀彈,而是在一致性、延遲、成本、復雜度之間不斷權衡與迭代的藝術。隨著硬件革新(如持久內存、DPU)和軟件理念(如Data Mesh去中心化數據架構)的發展,這一領域將繼續迎來深刻的變革,驅動網站向更智能、更敏捷的方向演進。